在之前的文章中,我们介绍了几款内置人工智能功能的代码编辑器。不过,这些功能通常依赖于云连接,可能需要订阅才能使用所有功能。如果你是离线工作,或者发现订阅费用超过了其好处,这可能会造成不便。

如果你正在寻找一个免费的离线替代方案,LM Studio 是一个不错的选择。这款桌面应用程序允许您直接在电脑上运行功能强大的大型语言模型(LLM)。您甚至可以从Ollama 平台提供的各种模型中进行选择。

在本文中,我们将介绍如何将 LM Studio 与 Visual Studio Code (VS Code) 结合使用,以便在代码编辑器中获得 AI 辅助。我们将介绍如何设置、连接到 VS Code 以及使用 AI 辅助功能。

准备工作

首先,请确保您准备好了一些东西:

- LM Studio:这是一款允许我们在电脑上本地运行人工智能模型的应用程序。如果您还没有安装,请查看我们的安装指南:如何使用 LM Studio 在本地计算机上运行 LLM。

- VS Code:如果你还没有 VS Code,可以从官方源下载。

设置LM Studio

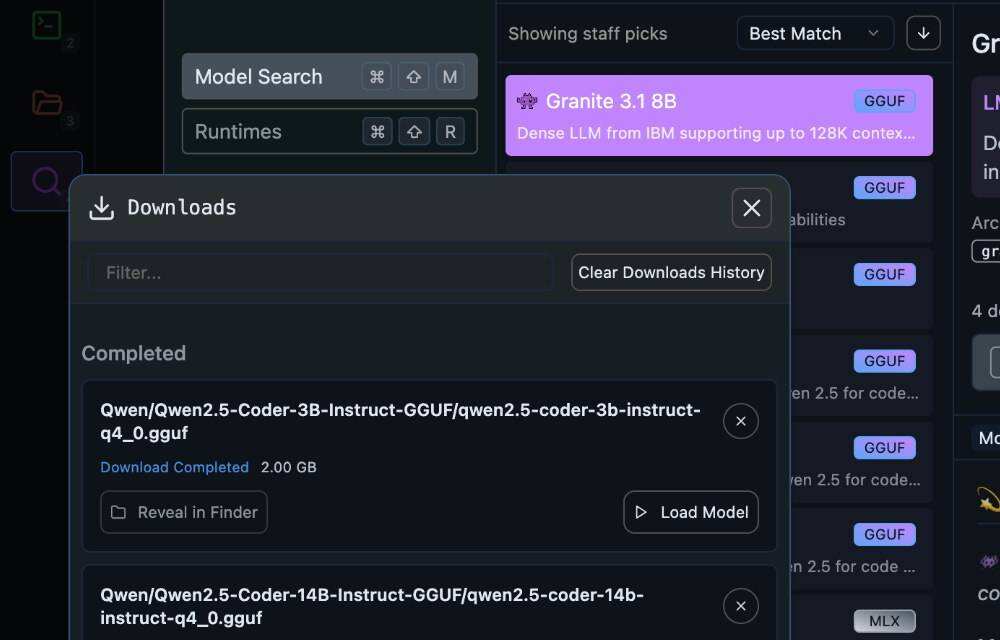

首先,打开 LM Studio 并下载要使用的 LLM。

对于编码辅助,最好选择专门针对代码训练的模型。在本例中,我们将使用拥有 140 亿个参数的“Qwen2.5 Coder”模型。

不过,选择一个能在电脑上流畅运行的模型也很重要。如果 14B 参数模型太重,可以尝试 3B 参数版本。

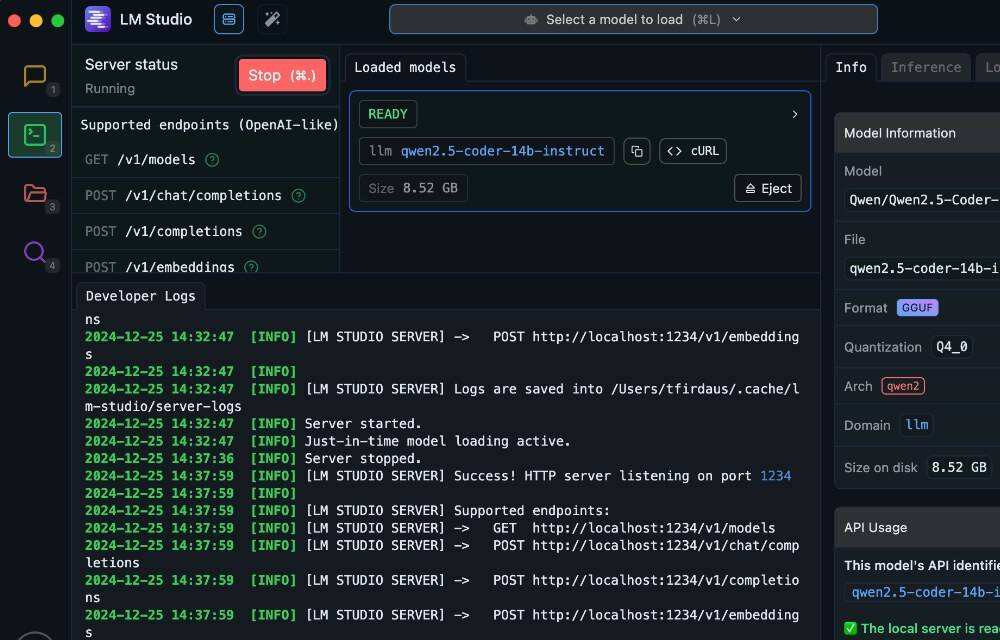

下载 LLM 后,将其载入 LM Studio 并启动服务器。您可以在侧边栏的“Developers”面板中找到服务器控件,如下图所示。服务器应该在 http://localhost:1234 开始运行,你会看到列出的可用端点。

将LM Studio连接到VS Code

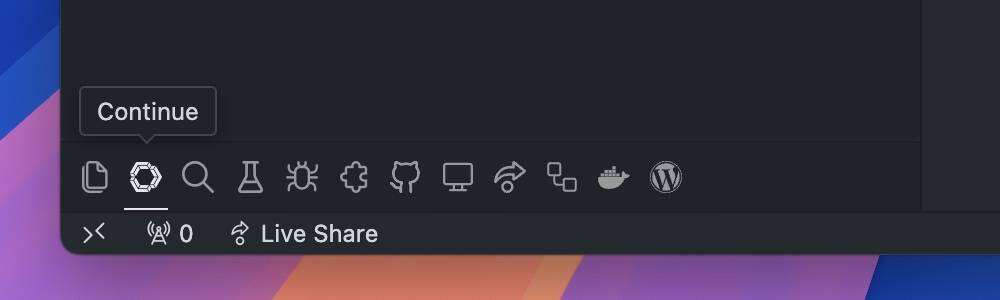

为了在 VS Code 中利用 LM Studio 的人工智能功能,我们将安装开源扩展 Continue.dev 。该扩展专门用于人工智能代码辅助,因此非常适合我们的需求。

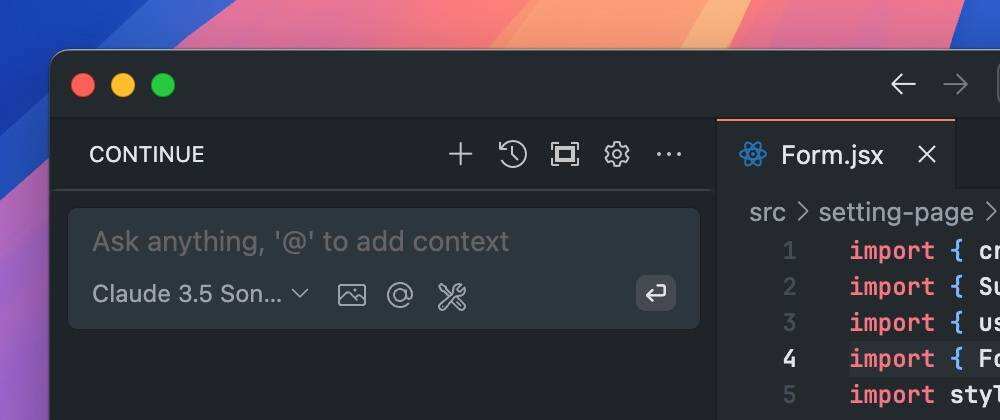

安装完成后,你会看到 VS 代码侧边栏出现一个新标签。这就是“Continue”选项卡。

在该选项卡中,我们可以找到“Chat”字段,在这里您可以与 AI 助手进行互动。

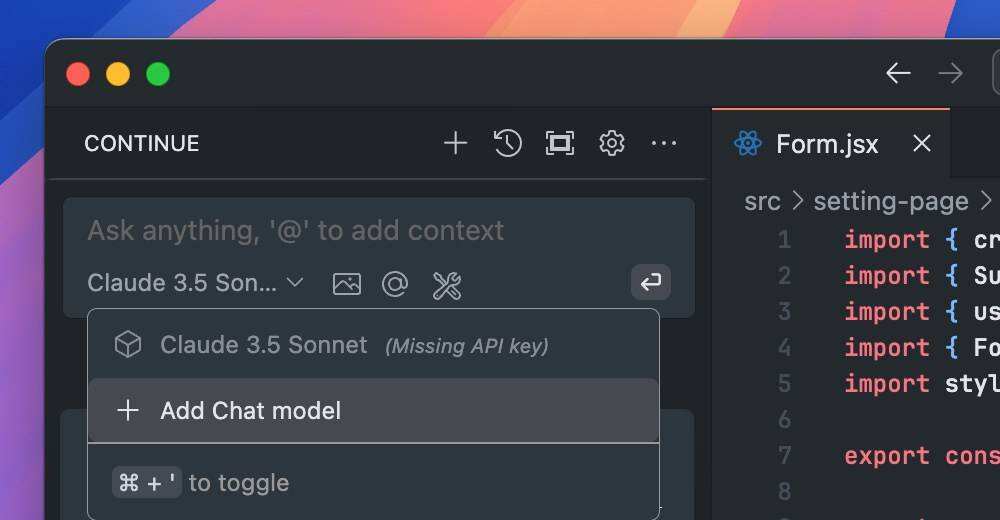

虽然聊天字段似乎可以使用,但它还不能工作或响应您的查询。我们需要为聊天选择 LLM 模型。要启用它,请单击字段底部的 Model 选项,然后选择 + Add Chat model

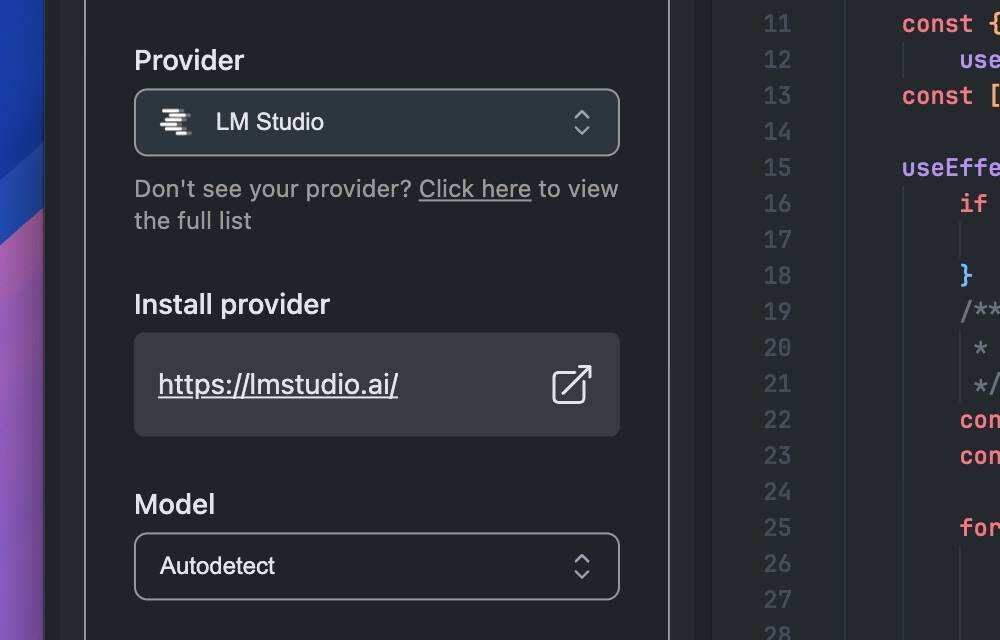

选择“LLM Studio”作为 Provider,“Autodetect”作为 Model。

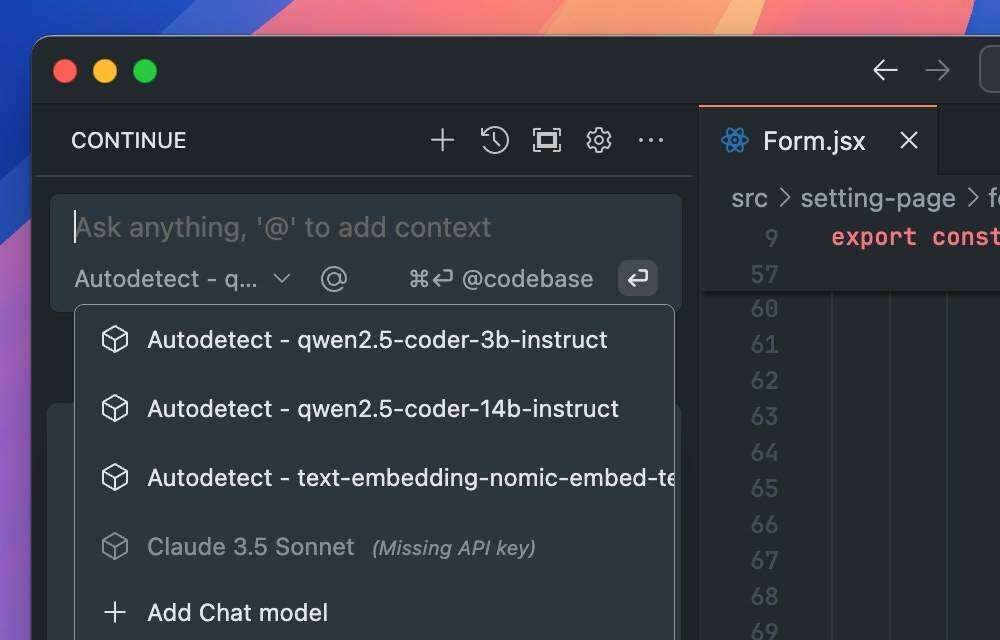

连接后,聊天栏将显示 LM Studio 中可用的 LLM 模型。在本例中,我们将选择在 LM Studio 中下载并设置的“Qwen2.5 Coder with 14B”模型。

使用聊天栏

聊天栏的工作原理与其他 AI 助手类似。您可以通过提问、请求建议甚至生成代码片段等方式与它互动。下面是一些示例:

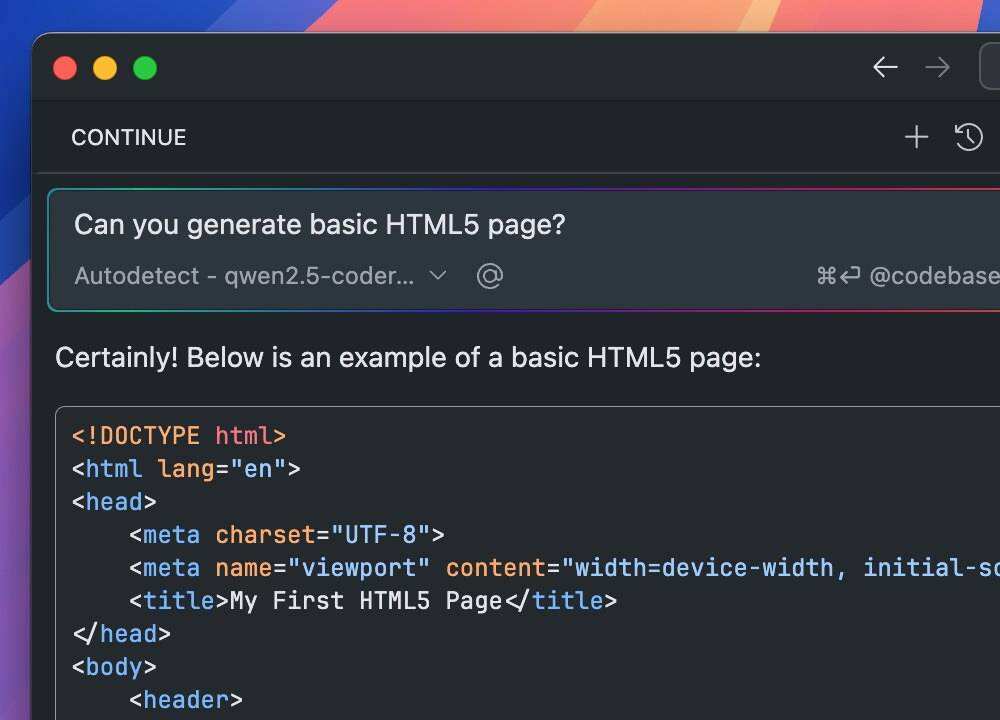

询问一个简单的 HTML 文档片段:

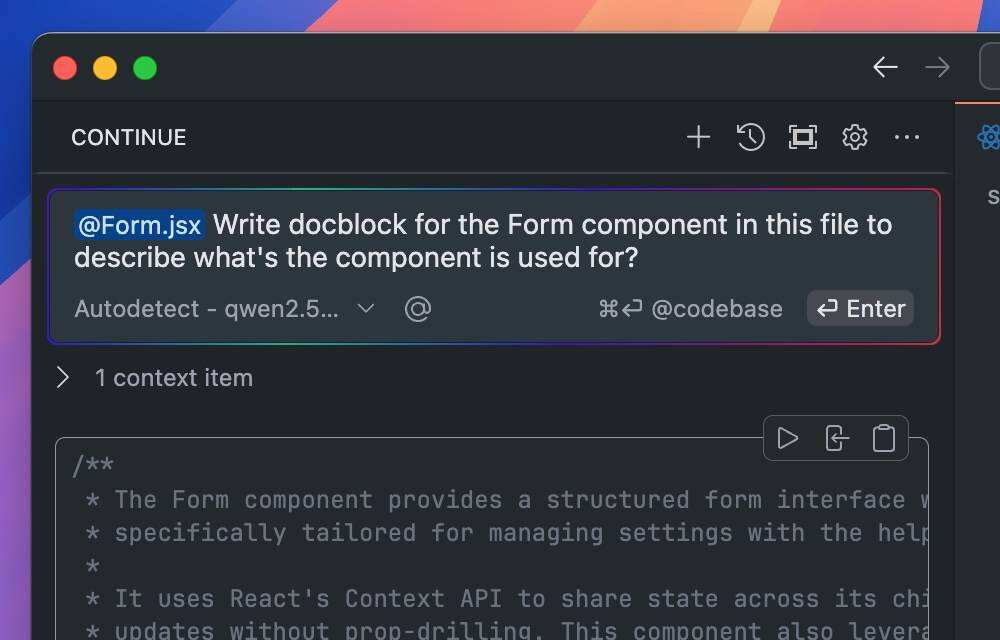

使用 @ 符号并选择“Files”来提供上下文。例如,附加当前文件以生成特定组件的 docblock。

配置代码自动补全

代码自动补全是 AI 代码编辑器中最常见的功能之一。在本例中,Continue.dev + VS Code 设置可能尚未启用。要启用它,请打开 ~/.continue/config.json 中的配置文件,并添加以下内容,以便将自动完成功能连接到 LM Studio。

{

"tabAutocompleteModel": {

"apiBase": "http://localhost:1234/v1/",

"title": "Qwen2.5-Coder 14B",

"provider": "lmstudio",

"model": "qwen2.5-coder:14b"

}

}

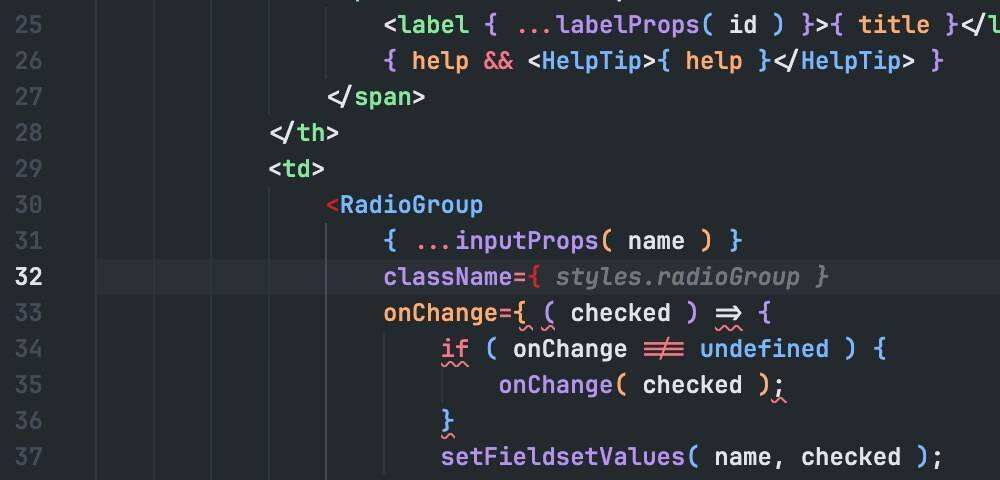

设置完成并保存后,您就可以在 VS 代码编辑器中看到代码自动补全功能。

小结

这就是如何在 Visual Studio Code 中使用 LM Studio 进行人工智能辅助。这是一种在代码编辑器中使用人工智能辅助的好方法,无需依赖云。它也是免费的,你可以选择最适合你电脑的模型。它是 OpenAI 或 GitHub Copilot 等云服务的最佳替代品。

试试吧,看看它能如何帮助你完成编码任务。

暂无评论内容